СДЛ шаг за шагом. Часть 1.1 — Внутренняя оптимизация.

Как я упоминал во введении, будет серия из статей о том, как сделать качественный и хороший ресурс (или сайт, как удобнее), который можно будет легко использовать как средство повышения своего дохода на продаже ссылок. Эта статья является первой из данной серии, сколько их будет – не знаю, как уж выйдет. После недельного отпуска и рассуждений я пришел к выводу, что сайт, который я буду делать в рамках данного мероприятия, будет не только под продажу ссылок, но и под трафик. Ссылки ссылками, но продвижение по трафику меня больше привлекает. ;) Что ни говори, а трафик монетизируется гораздо лучше, чем ссылки и он никогда не заспамит ваш сайт.

В качестве подопытного я взял один из своих нулевых сайтов: http://nogti.by (UPD домен уже не мой). Домен свосем молодой, еще нет и полугода, самому сайту нет и 2 месяцев – первая статья написана и размещена в конце июня.

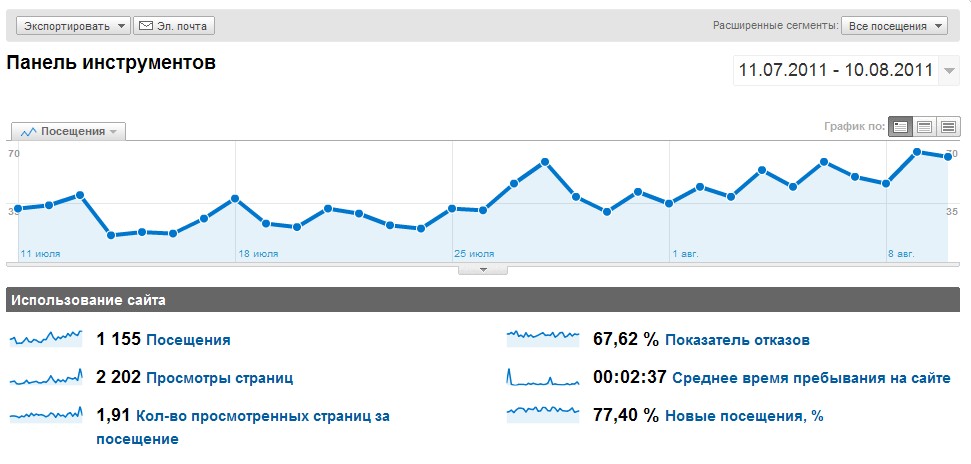

Сайт никак не продвигался, кроме 1 покупной ссылки в GGL со статьи на морду, только ради забавы. В данный момент там висит 6 статей, которые благополучно проиндексированы ПСами. Шкурка взята стандартная, новостная, под названием Chanell Pro, которая в процессе развития самого сайта будет сильно видоизменяться и дорабатываться. Работы еще много, поэтому будем делать все постепенно. На данный момент на сайте посещалка из поиска – 40 человек в сутки.

Вот скрин аналитика: (кликабельно)

Почему именно женская тематика и именно ногтей? Отвечу просто – я люблю работать с женским трафиком и мне понравился этот свободный домен.

Дано: Nogti.by

Дата регистрации: 13.04.2011 (Почти 4 месяца)

Первая статья: 27.06.2011 (Почти 1,5 месяца)

Внешних ссылок: 1 (По Я. Вебмастеру)

ТИЦ=0

PR=3 (Гугл в последнее время в конец спятил – давать нулевому сайту троечку ;)

Цель: Сделать качественный сайт, который с легкостью примут в GGL. Я буду делать сайт не для того, чтобы продавать с него ссылки, это не есть моя цель. Я буду поднимать трафик и делать портал по ногтям, который в последствии как-нибудь да монетизируется. Но я сделаю так, чтобы его легко приняли в ГГЛ.

Если у вас есть какой-нибудь нулевой или не очень проект, и вы желаете проделать весь этот путь вместе со мной – милости прошу. Вы будете делать сайт, повторяя все мои шаги, его примут в GGL, и после этого вы будете спокойно продавать ссылки и зарабатывать денежку. Плюс к этому – получите бесценный опыт и практику. Мне даже веселее будет ;)

Дополнительная цель: Поднять трафик до 2000 чел/сутки.

Начнем сначала.

1. Настройка ЧПУ.

ЧПУ (Человеко Понятные Урлы). Чтобы было понятнее – вместо http://nogti.by/123/123 в адресе страницы будет написано http://nogti.by/uroki/naraschivanie-nogtei.html.

Есть несколько самых распространенных вариантов урлов:

1. http://nogti.by/?p54

2. http://nogti.by/наращивание-ногтей

3. http://nogti.by/наращивание_ногтей

4. http://nogti.by/naraschivanie-nogtei

5. http://nogti.by/naraschivanie_nogtei

6. http://nogti.by/наращиваниеногтей

7. http://nogti.by/naraschivanienogtei

8. http://nogti.by/uslugi/naraschivanie-nogtei

9. http://nogti.by/uslugi /naraschivanie-nogtei.html

Каждый своему блогу хозяин и каждый сам решает, какой вариант лучше выбрать. Меня больше всего привлекает вариант номер 9. Хотя, с точки зрения SEO, хороши также 4 и 8. Но мне нравится, когда в конце стоит частичка html. ;)

ЧПУ сильно влияет на ранжирование, вхождение ключа в адрес страницы – большой и жирный плюс со стороны поисковых систем. Не стоит им пренебрегать. Я выбрал номер девять также потому, что в урл входит название категории, в которой находится статья. Яндекс по урлам распознает структуру сайта и, когда вы на топовых позициях, может показывать быстрые ссылки. Плюс к тому, когда есть нечто общее в урлах – можно легко манипулировать сайтом и, к примеру, закрыть ненужный вам раздел в файле robots.txt, использовав всего 1 директиву.

Как настроить данный вид урлов:

1. Идем в админку вордпресса.

2. Настройки => Постоянные ссылки (ЧПУ). И пишем там в поле вот эту строчку:

/%category%/%postname%.html

которая преобразует урлы в вид:

категория/название статьи/ и в конце прибавляет .html

Скрин прилагается:

2. Настройка robots.txt.

Для тех, кто не знает, что такое роботс – маленький файлик, который лежит на хостинге и указывает поисковым роботам, какой контент на сайте можно индексировать, а какой нельзя. Перед тем, как приступить к индексации, роботы читают то, что там написано и кушают только те страницы, которые не запрещены в этом файле. Для вордпресса есть стандартный шаблонный роботс, который можно просто скопировать. Далее – в зависимости от вашей темы, вида ваших урлов и ваших особых пожеланий – можно дополнять его и видоизменять.

Вот этот шаблонный вариант:

User-agent: *

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /webstat/

Disallow: /feed/

Disallow: /trackback

Disallow: */trackback

Disallow: */feed

Disallow: /*?*

Disallow: /wp-content/

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /page/*

Disallow: /author/*

User-agent: Yandex

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /webstat/

Disallow: /feed/

Disallow: /trackback

Disallow: */trackback

Disallow: */feed

Disallow: /*?*

Disallow: /wp-content/

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /page/*

Disallow: /author/*

Host: nogti.by

Sitemap: http://nogti.by/sitemap.xml

*Вместо nogti.by поставьте название своего сайта.

Коротко:

- Disallow: — запретить к индексации раздел, подраздел, страницу…

- Sitemap: — путь к карте сайта в формате xml. (Создается плагином, до него еще дойдем)

- Host: — директива для Яндекса – здесь указывается главное зеркало сайта (с www или без).

Мой роботс сейчас настроен так, чтобы в индекс попадали только отдельные записи и статические страницы. Чуть позже я его немного видоизменю и подкорректирую.

Если у вас на хостинге не будет подобного файлика, роботы будут индексировать все подряд, что чревато плохими последствиями. В поиске будет много страниц, которые не несут никакой пользы для посетителя и куча дублированного контента внутри домена. А нам он нисколько не нужен, он мешает продвижению.

Помните о том, что при настройке robots.txt главным является следующее:

- В поиске должны остаться только страницы отдельных записей, статические страницы и страницы категорий (последние — по желанию).

- Страницы архивов, постраничная навигация, страницы сортировок и т.д. – это все мусор, который не стоит держать в поиске.

- Правильно пишите команды для роботов.

На этом, я думаю, первый выпуск серии статей закончится.

Если у вас есть какие-нибудь вопросы, я буду рад на них ответить в комментариях.

Продолжение следует. ;)

Твит дня: «- Ты изменяла? — Ну, было разок… с соседом… — Я спрашиваю: ты пароль для входа в твиттер изменяла?»

- Скрипт красивого падающего снега для сайта (HTML код + javascript)

- Ошибка WordPress — формирование дублей страниц пагинации на конце URL с «canonical» и 200 ответом сервера

- Возможности, которые даже не рассматриваются.

- Интервью: Андрей Бушмакин (юрист) о манимейкинге в РБ

- А вы все еще не тестируете?

Интересная статья, буду следить за продолжением.

Да, Дима! Отлично! По поводу трафика согласен! Его монетизировать гораздо легче! Бери НЧ запросы и вперед:)

C НЧ начнем только) ВЧ — обязаточное условие тоже ;)

Молодцом, Дима! Тематика выбраного подопечного очень актуальная… по своему сайту вижу. Буду следить за успехами твоего портала, заодно в конкуренции дополнительный стимул к развитию своего блога)))

Ром, у нас с тобой немного разные цели ;)

спасибо, попробуем подредактировать robots.txt

А я еще закрываю в роботсе Disallow: /tag/, чтобы лишних дублей не появлялось.

Нашел много интересного на сайте, спасибо -)

Сейчас как раз пробую раскрутить сдл под контекст, воспользуюсь вашими советами. И спасибо за подкаст по ГГЛ ;-)

у меня вопросик по поводу ссылок в вп, поставил как описывается здесь, но ссылки все равно формируются на русском, как сделать, чтобы это было на английском? Спасибо!

Алексей: читать СДЛ шаг за шагом часть 1.2

А стоит ли закрывать wp-content, в котором могут лежать картинки?

нет, картинки нужно открывать от индексации

Это я к тому, что в вашем примере wp-content закрыт. :)

У меня картинки открыты.

Я не пойму, а как Вам удается получать трафик 40 уников в день с нулевого сайта у которого 6 страниц? Или это трафик не с поиска?

Правильная оптимизация, как же еще)

На кулинарии, к примеру, 5 правильно оптимизированных страниц с рецептами дают стабильно 120-140 уников в сутки из поиска.

Заинтриговали, правильной оптимизацией))) Очень интересно что именно Вы имеете ввиду, правильное семантическое трафиковое ядро, внутреннюю перелинковку или что то еще? Просто те запросы в которых есть трафик вряд ли получится молодому сайту получить в ТОП, тогда возникает вопрос как Вам это удается? Или вы знаете как находить микро НЧ у которых высокий трафик? Если это так, то где у вас можно почитать на блоге такую инфу, как их находить? Если вы конечно захотите рассказать такую ценную информацию))) Я бы многое отдал за эти знания.

А сайтик то ваш не доступен, видать не пошла тема или забыли проплаттьь хост аль домен?) Гляньте мой сайтик в чем его ошибки?) Спс)

На блоге этого нет, я про это рассказываю на платном обучении.

День добрый, у меня проиндексировались теги (страницы с поиском по тегам). Нужно ли их закрывать от индексации?

Да, если вы их не продвигаете. Я всегда закрываю.